今回紹介するのは、ソニーのmocopiとLeap Motionの機材を持っている人向けに

フルトラッキングができる方法を紹介したいと思います。

また、表情をトラッキングをするために、iFacialMocapアプリが動く、

もう1つ、A12 Bionicチップ以降を搭載した (iOS14以降)iPhone、もしくはiPadも必要です。

通常、iPhoneを2台持っている人は少ないと思いますが、iPadなら持っている人はいらっしゃるかと思います。

もちろんPCも必要です。

機材がたくさん必要ですが、比較的手軽に低予算でフルトラッキングができる環境を作ることができますので紹介させていただきます。

まず、必要な機材は以下になります。

今回使用する機材

・ソニーmocopi (全身トラッキング用)

・iPhone(mocopiアプリ用)

・iPhone又はiPad(表情トラッキング用のiFacialMocapアプリ)

・Ultraleap Leap Motion コントローラ 2 (手の動きトラッキング用)

・PC

今回使用するアプリ

・mocopi(無料)【iOSアプリ】

・iFacialMocap(無料)【iOSアプリ】

・VSeeFace(無料)【PCアプリ】

・VirtualMotionCapture(有料:先行リリース版)PIXIV FANBOXの300円〜の支援でダウンロード可【PCアプリ】

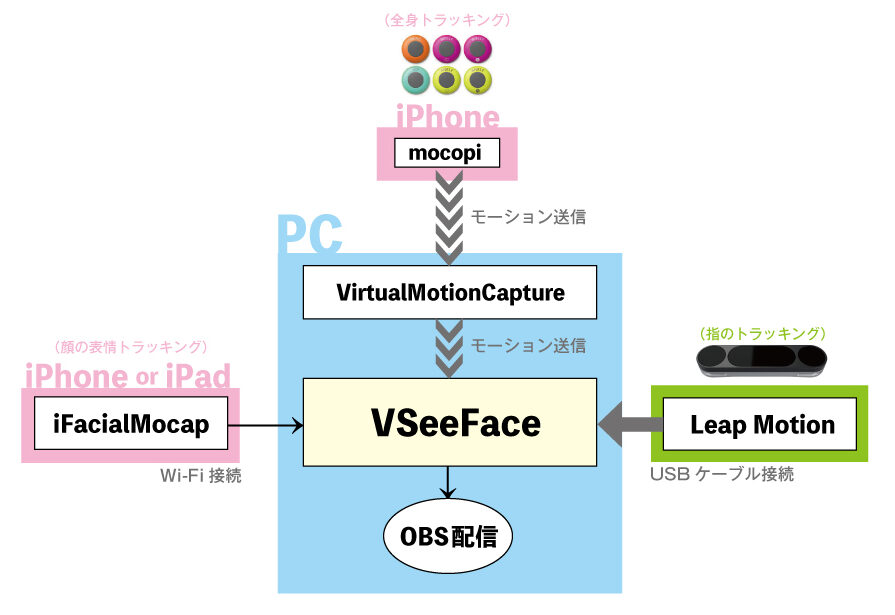

接続図

今回紹介する機材とアプリの全体の接続図です。

最終的にVSeeFaceに統合して、OBSで配信する感じです。

フルトラッキングの設定

それでは、少し長くなりますが、設定していきます。

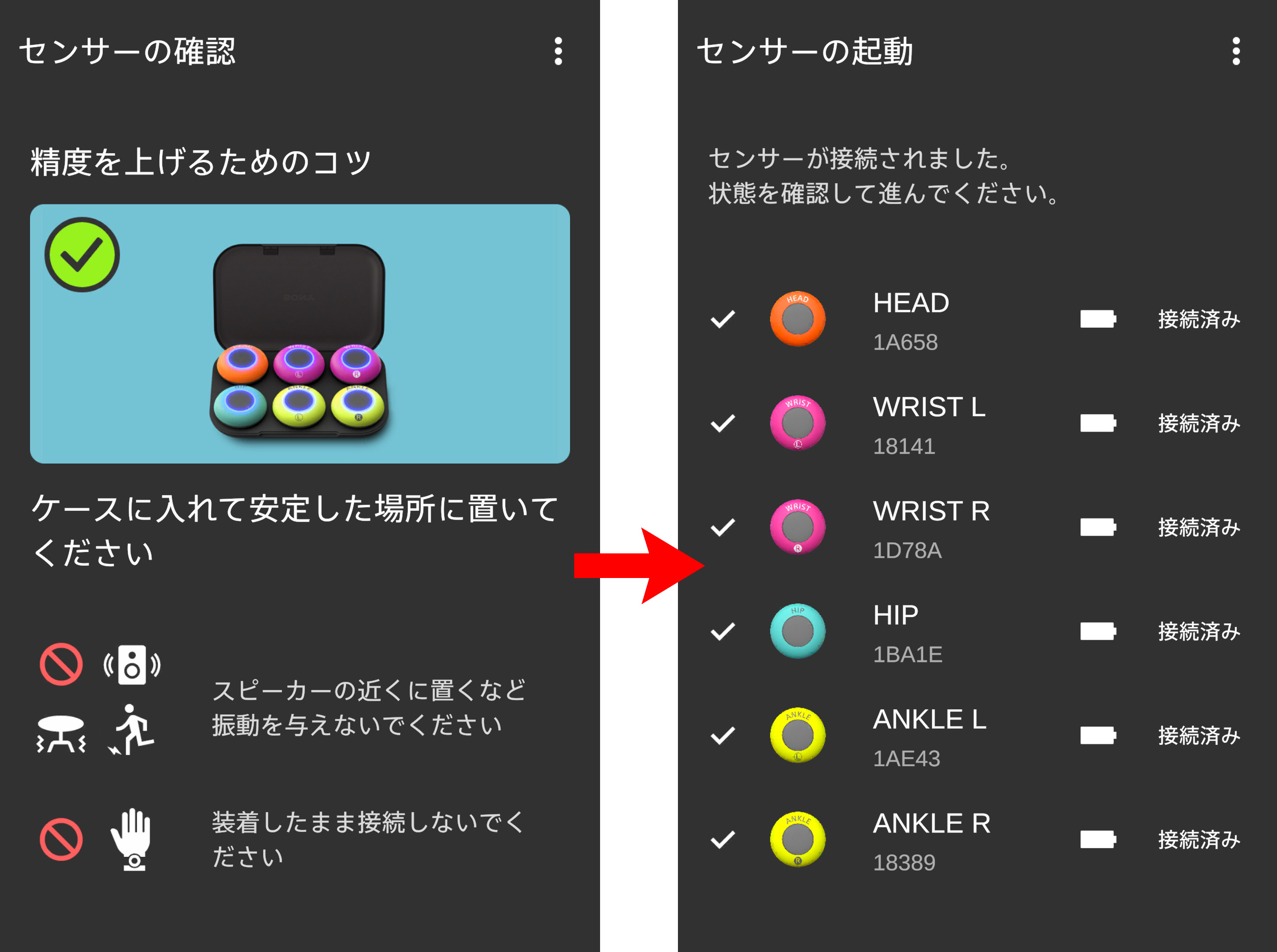

1.mocopiを体に取付けてトラッキングする

mocopiをケースに入れたまま、すべての電源をオンにします。

mocopiを動かさないで、mocopiアプリと接続します。

アプリに接続できたら、頭、両手首、腰、両足首に取り付けます。

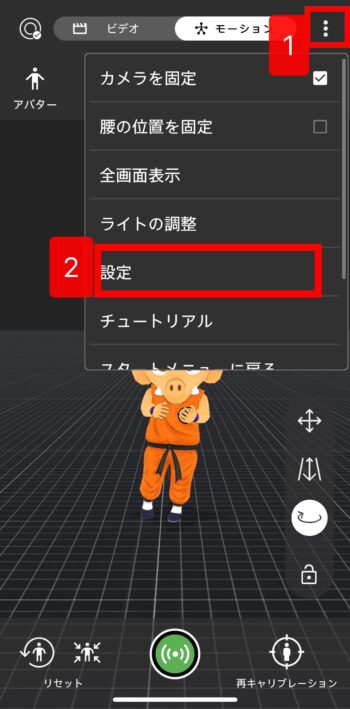

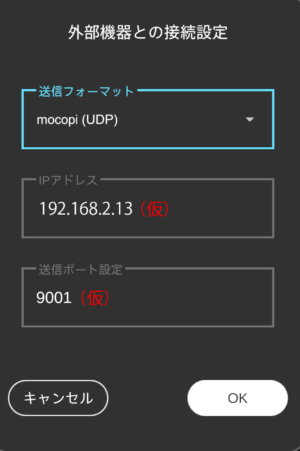

mocopiアプリ 外部機器との接続設定

mocopiアプリの右上の3点から、設定 > 外部機器との接続設定画面にいきます。

送信フォーマット:mocopi(UDP)

IPアドレス:使用するPCのIPアドレス

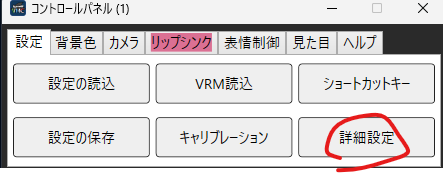

IPアドレスの確認はVirtualMotionCaptureを立ち上げて、コントロールパネルの詳細設定 > Check IPから確認できます。下記画像を確認してください。

送信ポート設定:多分なんでもいいと思います。

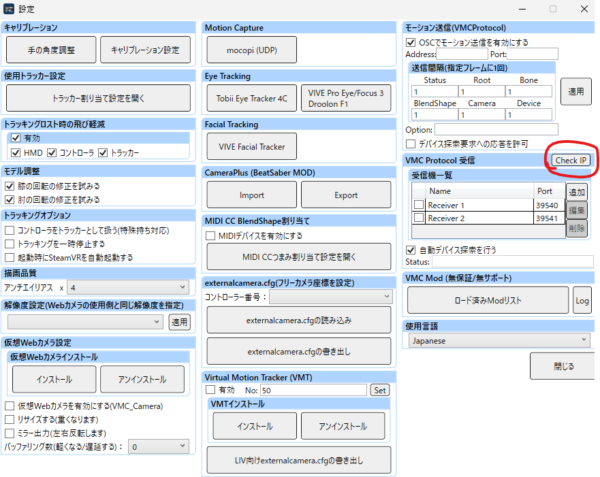

そして、mocopiアプリの下にある真ん中の緑ボタンでモーションを送信します。

これで一旦mocopiの設定は終了、次に進みます。

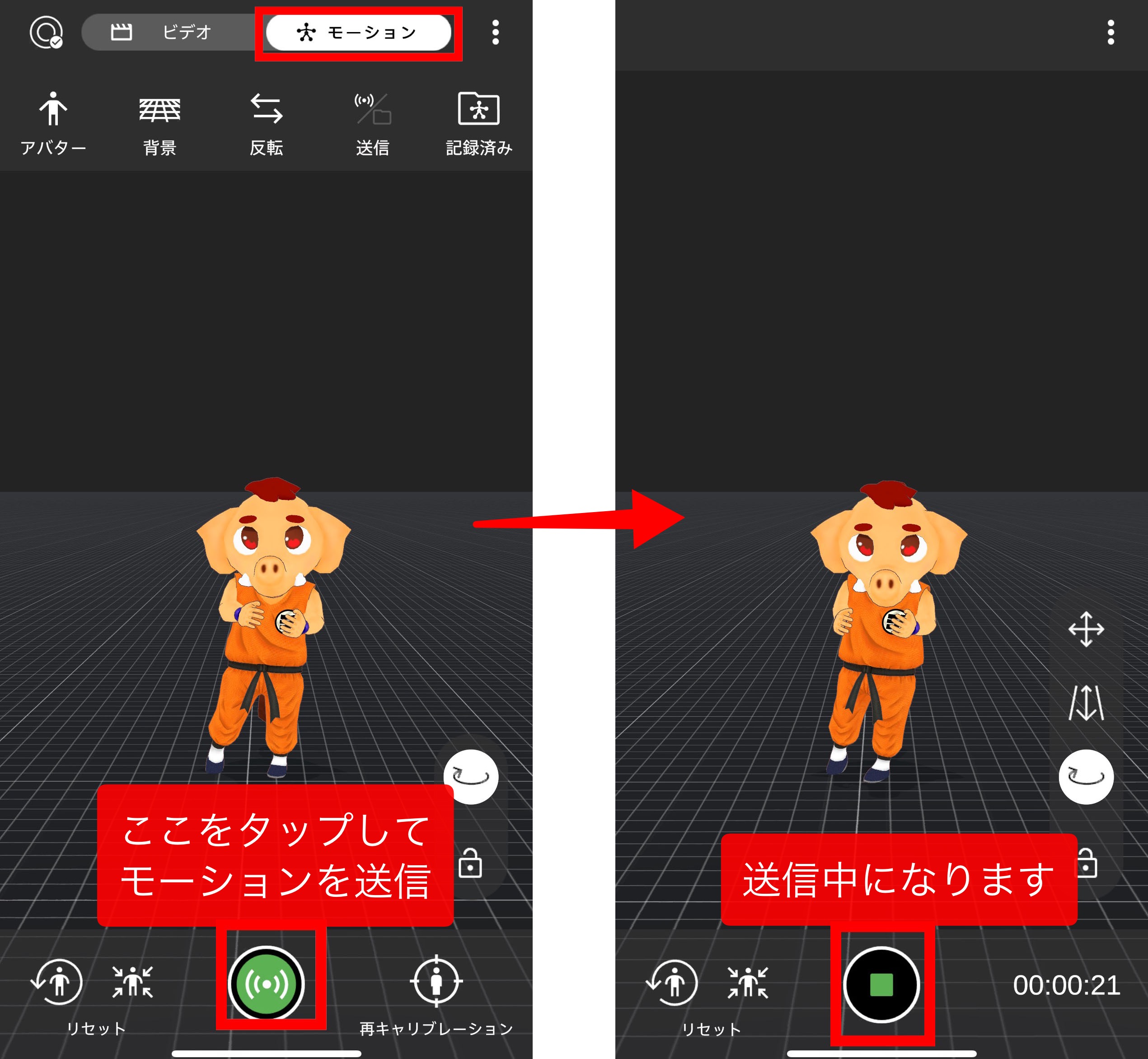

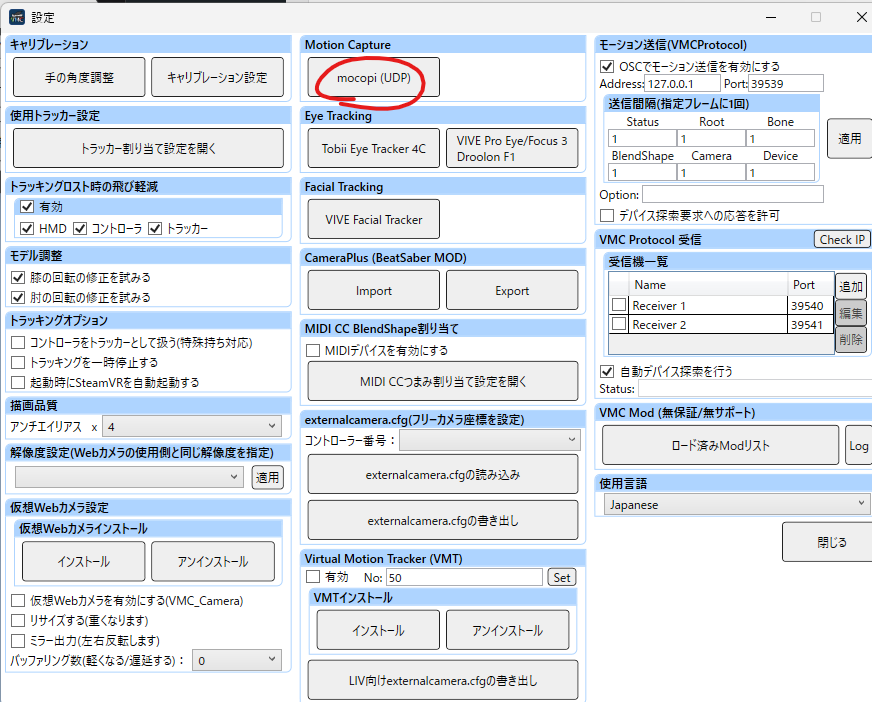

VirtualMotionCaptureの起動

mocopiを起動したまま、

続きまして、PCアプリのVirtualMotionCaptureに進みます。

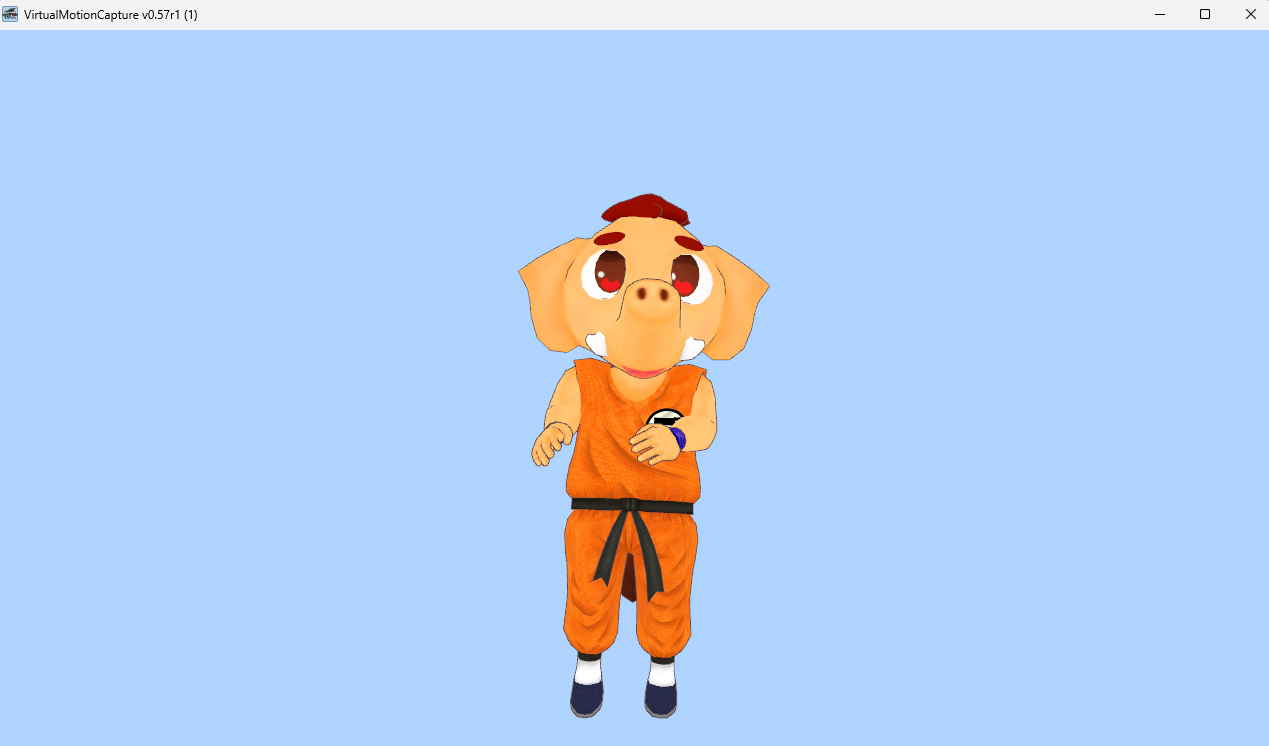

まず、アバターのvrmファイルを読み込みます。

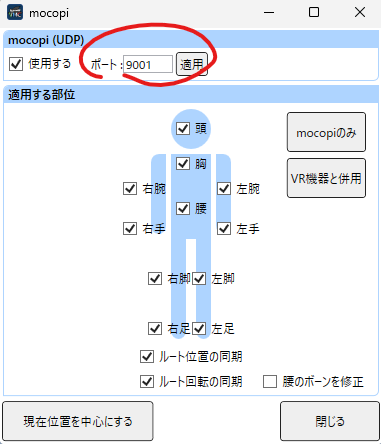

mocopi(UDP)ボタンを押します。

mocopiアプリの送信ポート設定にあったポート番号を入れて適用します。

これで、VirtualMotionCapture上で、mocopiを使ってアバター全身を動かすことができます。

体は動かせるようになりましたが、表情、指の動きはまだ動かせません。

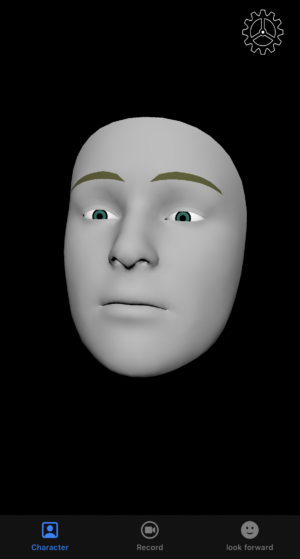

顔の表情トラッキングは、iFacialMocap(iOSアプリ)を使います。

しかし、mocopiアプリでiPhoneをすでに使用していますので、

もう一つ、iPhoneもしくは、iPadが必要です。

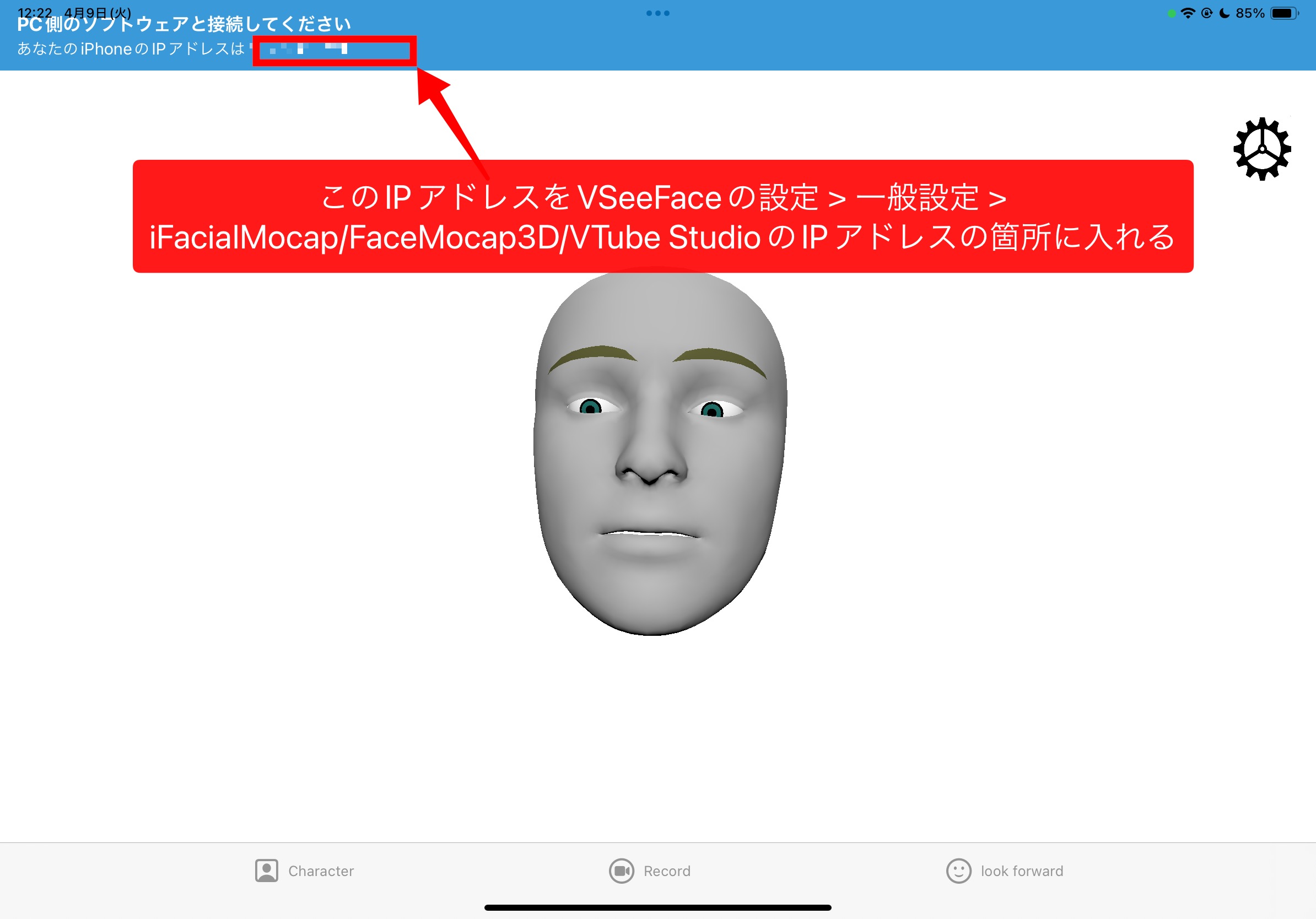

下記画像はiOSアプリ、iFacialMocapの画面です。

そして、指の動きはUltraleap Leap Motion コントローラ 2を使います。

下記画像は、自分の首に掛けれるようにしてます。

詳細はこの記事を参考になさってください

これらは、VirtualMotionCaptureでは使えません。

そこでVirtualMotionCapture上でmocopiを動かせるようになったモーションを

別のアプリのVSeeFaceに送信します。

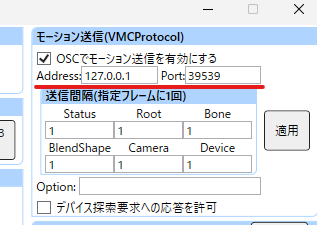

VirtualMotionCaptureからモーション送信する

VirtualMotionCaptureの設定画面の右上にある、OSCでモーション送信を有効にするをチェックを入れて適用します。

Address:127.0.0.1(仮) Port:39539(仮)を覚えておきます。

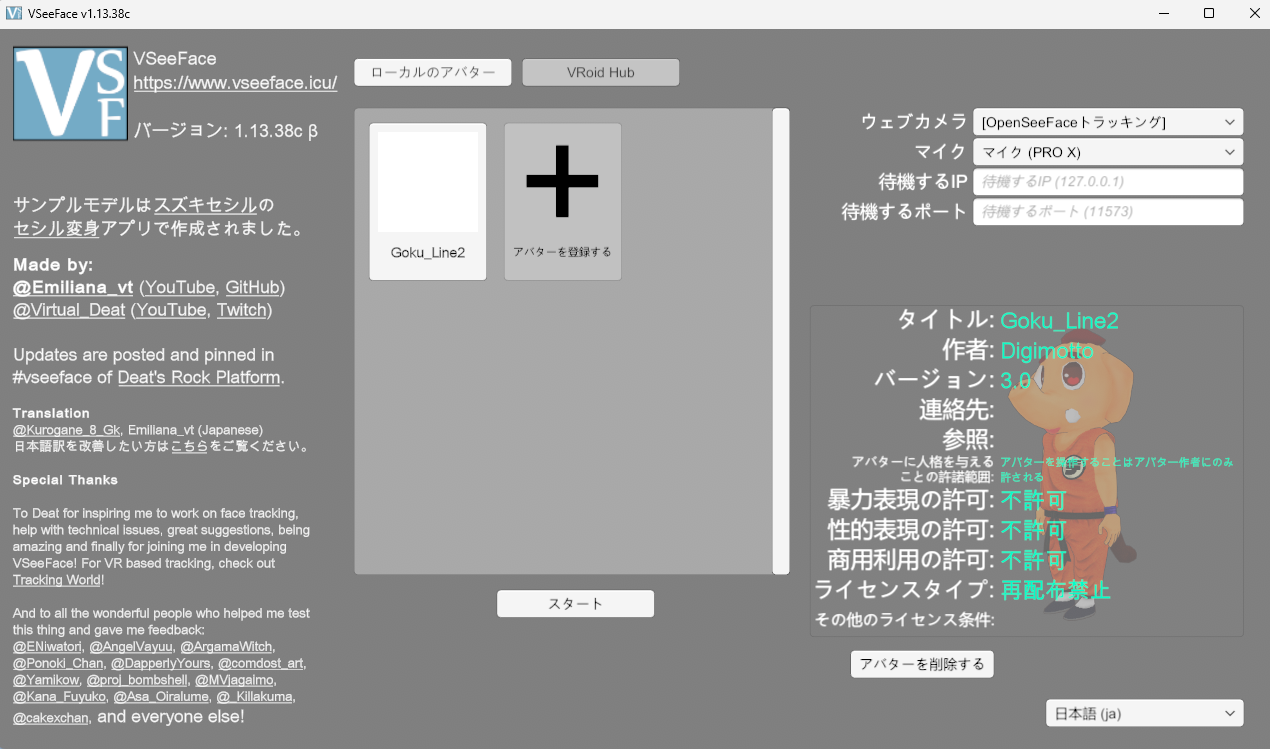

次に、VSeeFaceアプリを使います。

VSeeFaceを使う

VSeeFaceを立ち上げると、この画面になります。

アバターを選択します。

ウェブカメラ、マイクの設定をしてスタートをクリックします。

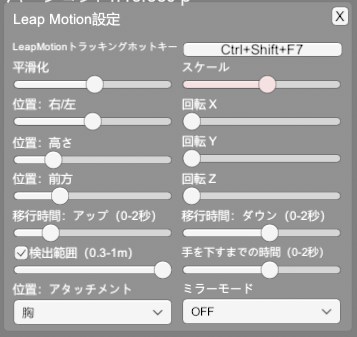

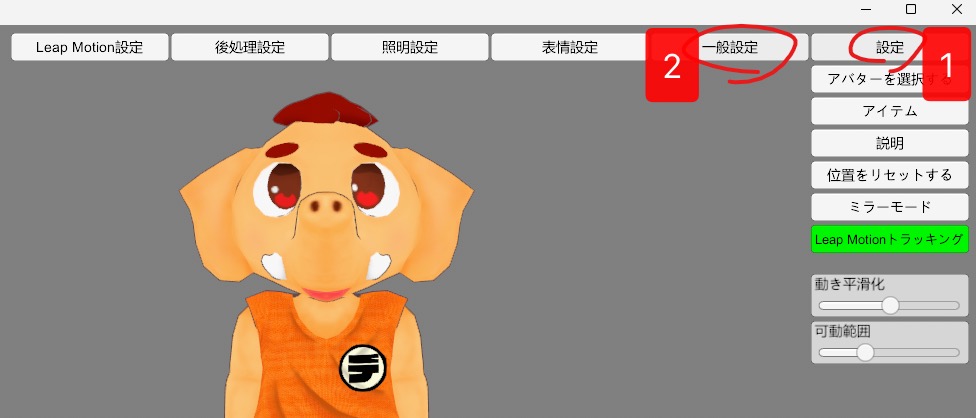

Leap Motionコントローラーで指をトラッキング

Leap MotionコントローラーをPCに接続しておきます。

次に、VSeeFaceを起動します。

VSeeFaceで、Leap Motionコントローラーを使えるように設定します。

続きまして、Leap Motion設定に進みます。

上画像にLeap Motionの取り付け場所が表示されています。

実際に取り付けている場所に合わせます。

デジモットの場合は、首にマウントしていますので胸元に取り付けています。

設定は下記のように設定しました。

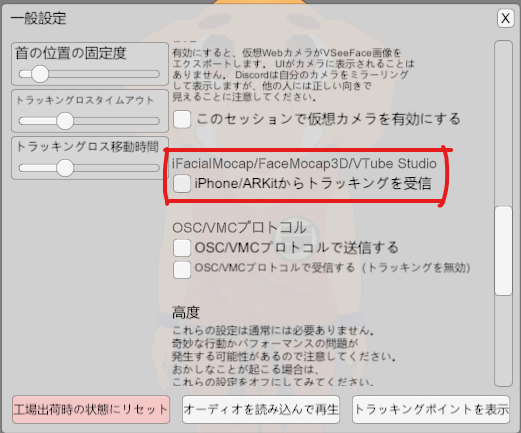

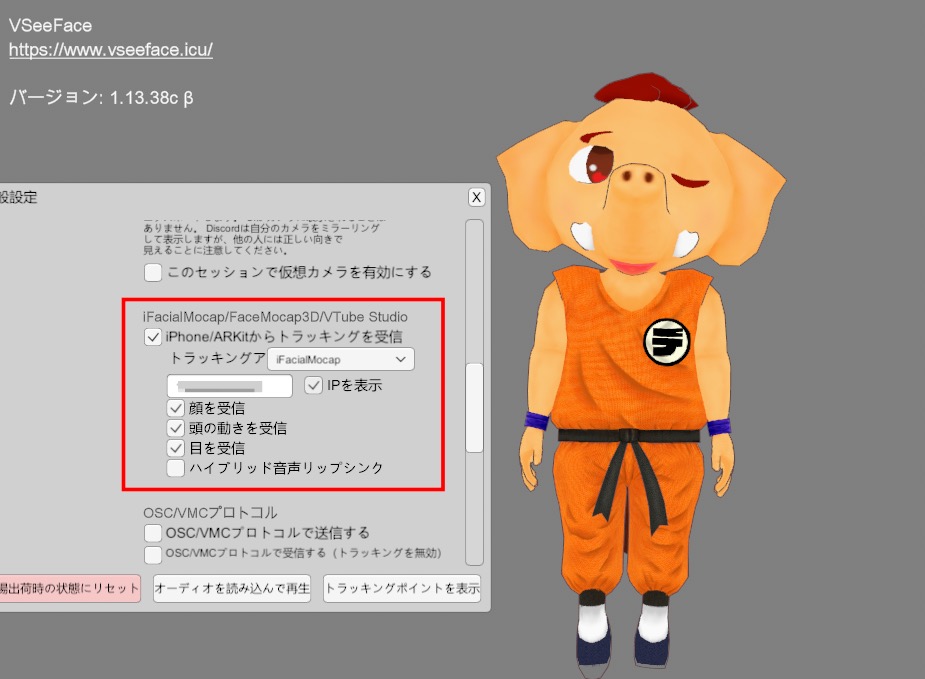

VSeeFaceでiFacialMocapで顔の表情をトラッキング

VSeeFaceでiFacialMocapを使用して、顔の表情を使えるようにします。

もう一つのiPhoneもしくは、iPadでiFacialMocapアプリを立ち上げます。

VSeeFaceの設定 > 一般設定へ進みます。

iPhone/ARKitからトラッキングを受信のチェックを入れる。

iPhone又は、iPadアプリのiFacialMocapの

上部のIPアドレスを覚えておき、VSeeFaceの設定 > 一般設定 > iFacialMocap/FaceMocap3D/VTube StudioのIPアドレスの入力箇所に入れます。

トラッキングアプリをiFacialMocapにします。

iFacialMocapアプリ上部のIPアドレスを入れます。

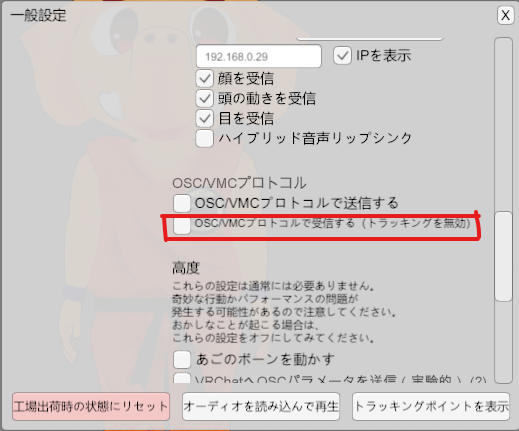

VirtualMotionCaptureで送信したOSCモーションを受信して全身を動かす

最初の方に、VirtualMotionCaptureで、OSCでモーション送信をしたのを受信します。

VSeeFace > 設定 > 一般設定 > OSC/VRMプロトコルで受信する(トラッキングを無効)のチェックを入れます。

これで、VirtualMotionCapture上でmocopiを使って全身のトラッキングの情報が、VSeeFaceに送られて、VSeeFace上で全身トラッキング、Leap Motionを使った指トラッキング、iFacialMocapを使った表情トラッキングができるようになりました。

注意)当然ですが、今まで使用したアプリはすべて立ち上げておいてください。

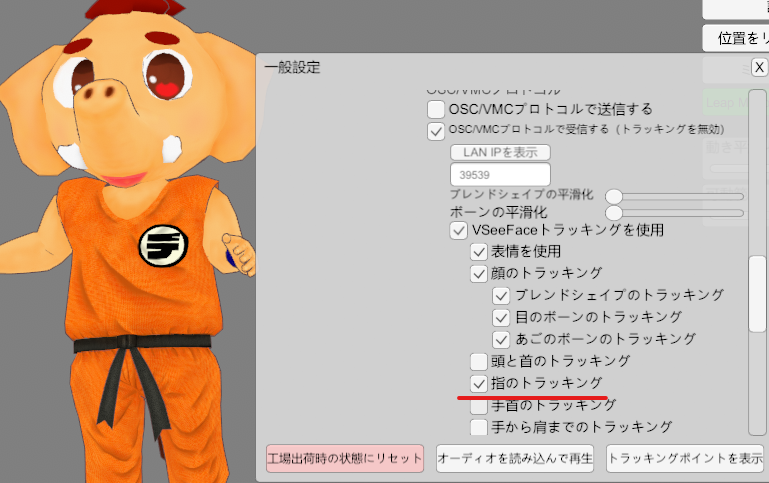

できたと思いきや、指が動かない場合があります。

その時は、下記画像の指のトラッキングのチェックを入れてください。

これで、指が動くようになります。

これで、OBSなどで配信することができます。

右下の※印のボタンで背景が透過することができます。

VSeeFaceはグリーンバックなど、背景の色を変更することができません。多分・・・。

グリーンバッグにしたい時は、OBSでグリーンバックのレイヤーを下のレイヤーに作るといいでしょう。

注意点はmocopiは時間が経つとズレが生じてきますので、時折リセットやキャリブレーションが必要です。

以上で、フルトラで配信や録画ができる環境の解説を終わりたいと思います。

機材も結構必要で、初めは結構複雑ですが、慣れてしまえば簡単です。