LuppetXを実際にやってみよう!

VRMファイルを選んでスタート

背景・環境設定から背景設定を選択。

今回、背景を透過する(OBS)のチェックを入れてみます。

キーボードのescキーで、右下に小さく表示されていたアバター画面が、全画面になります。

顔のトラッキングをしてみよう

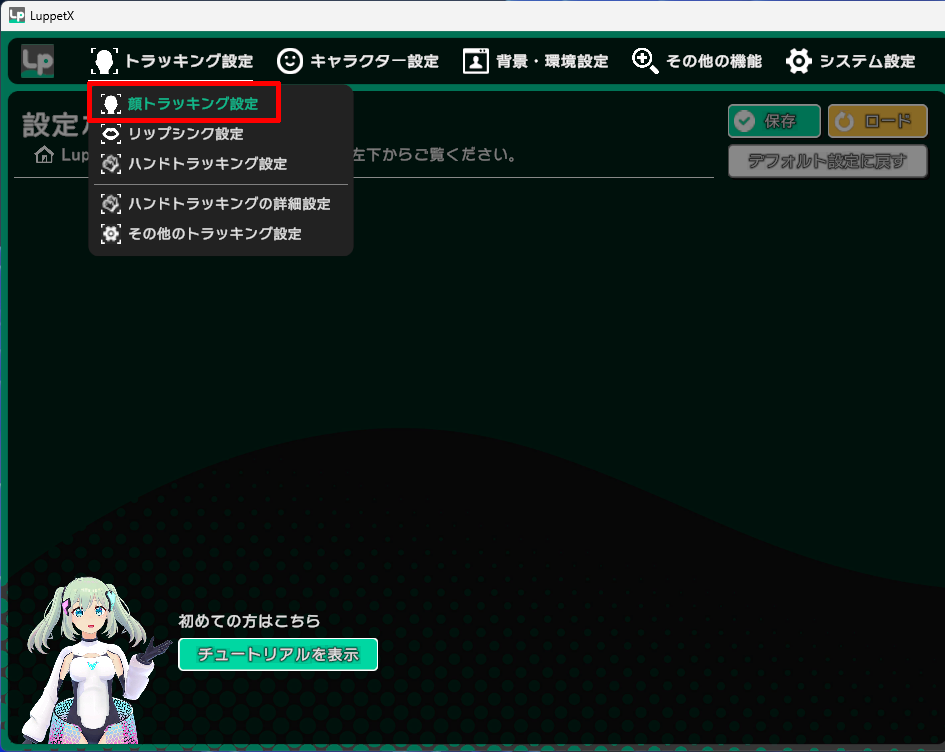

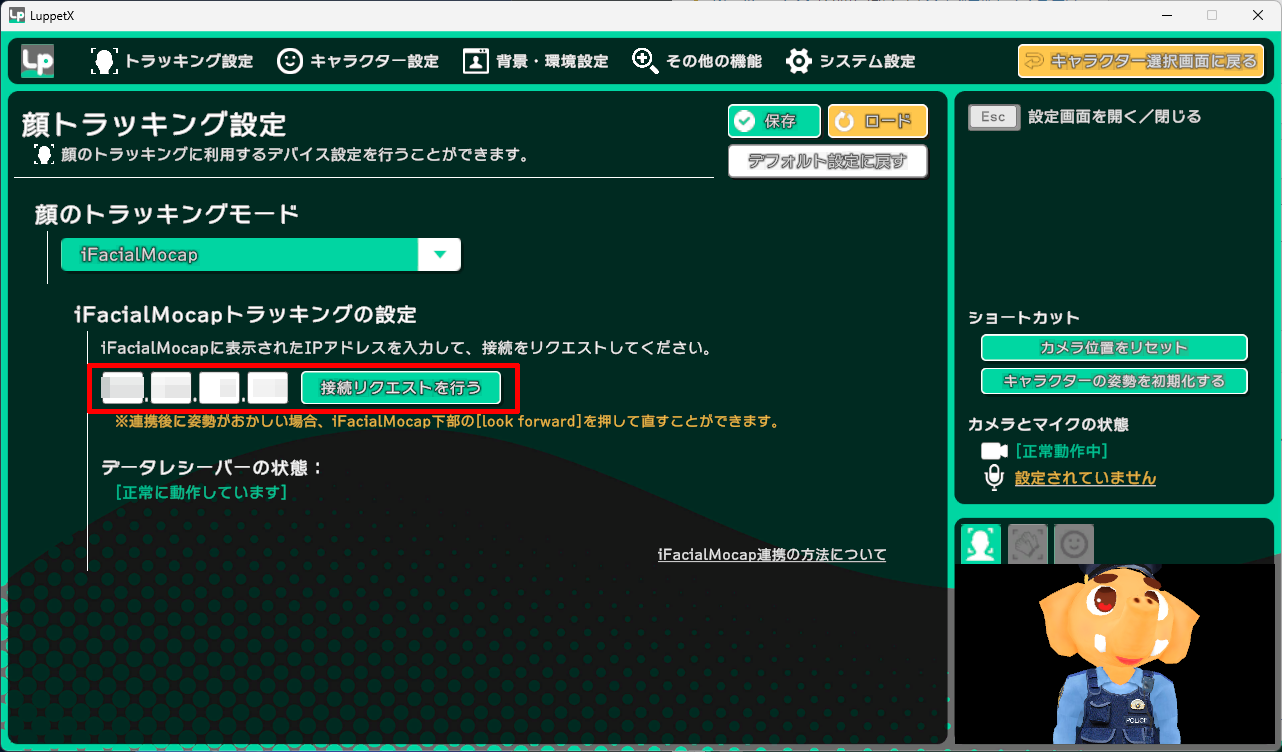

トラッキング設定> 顔トラッキング設定

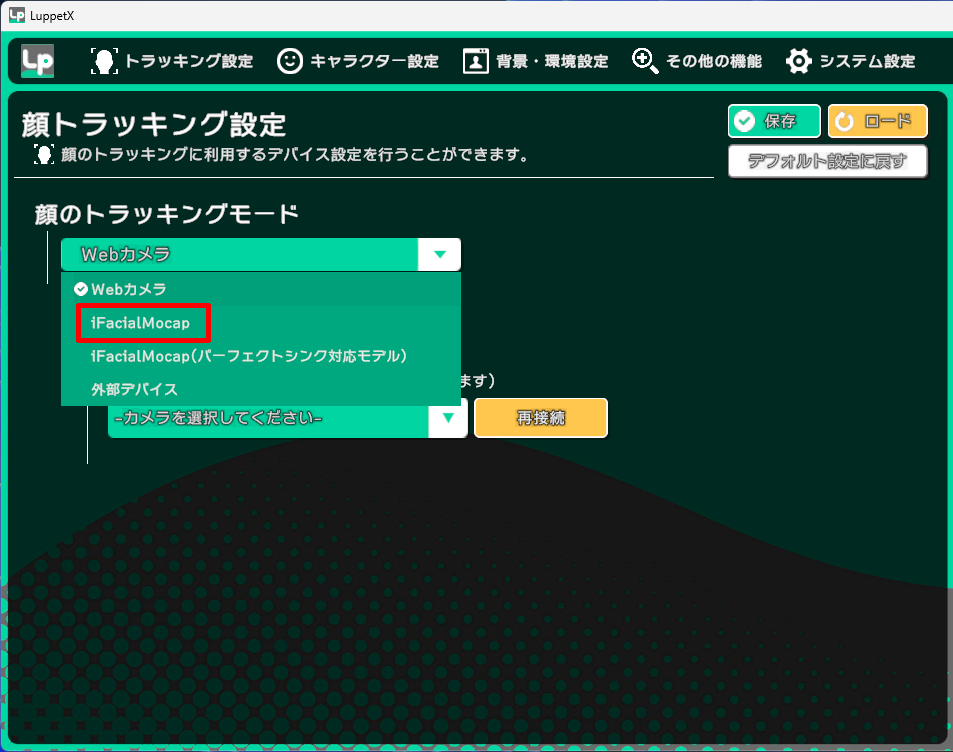

iFacialMocapを選択。

iFacialMocapはiPhoneのアプリです。このアプリで表示されるIPアドレスを打ち込みます。

iFacialMocap(iPhoneのiOSです)

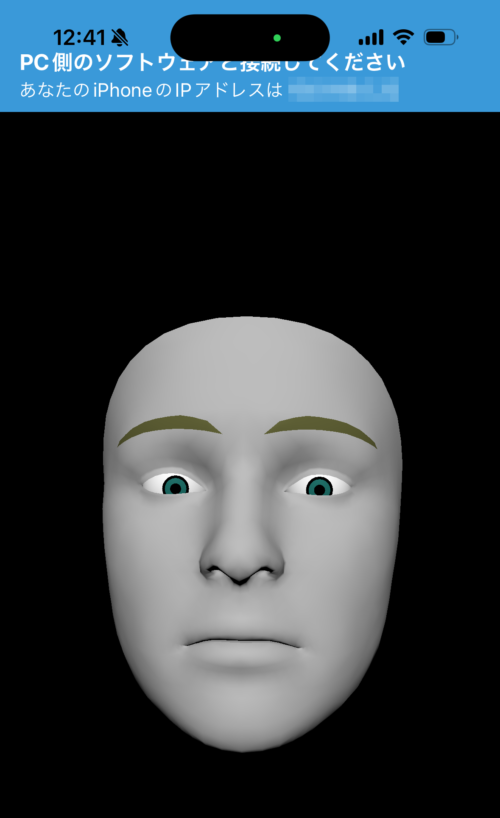

ここからは、iPhoneの設定です。

iPhoneから、iFacialMocapアプリをダウンロードし起動します。

起動するとこのような画面になります。

IPアドレスが上部に表示されますのでこのIPアドレスをPCのLuppetXに打ち込みます。

LuppetXにもどり、iFacialMocap(iOS)で表示されたIPアドレスをここに入れます。

接続リクエストを行うをクリックすると、iFacialMocap(iOS)で取得したデータがLuppetXに送信されます。

これで、頭を動かすと、アバターも同じように動きます。

トラッキング設定のリップシンクモードを顔トラッキングデータを利用でiPhoneのiFacialMocapの口の形のデータも使うことができます。

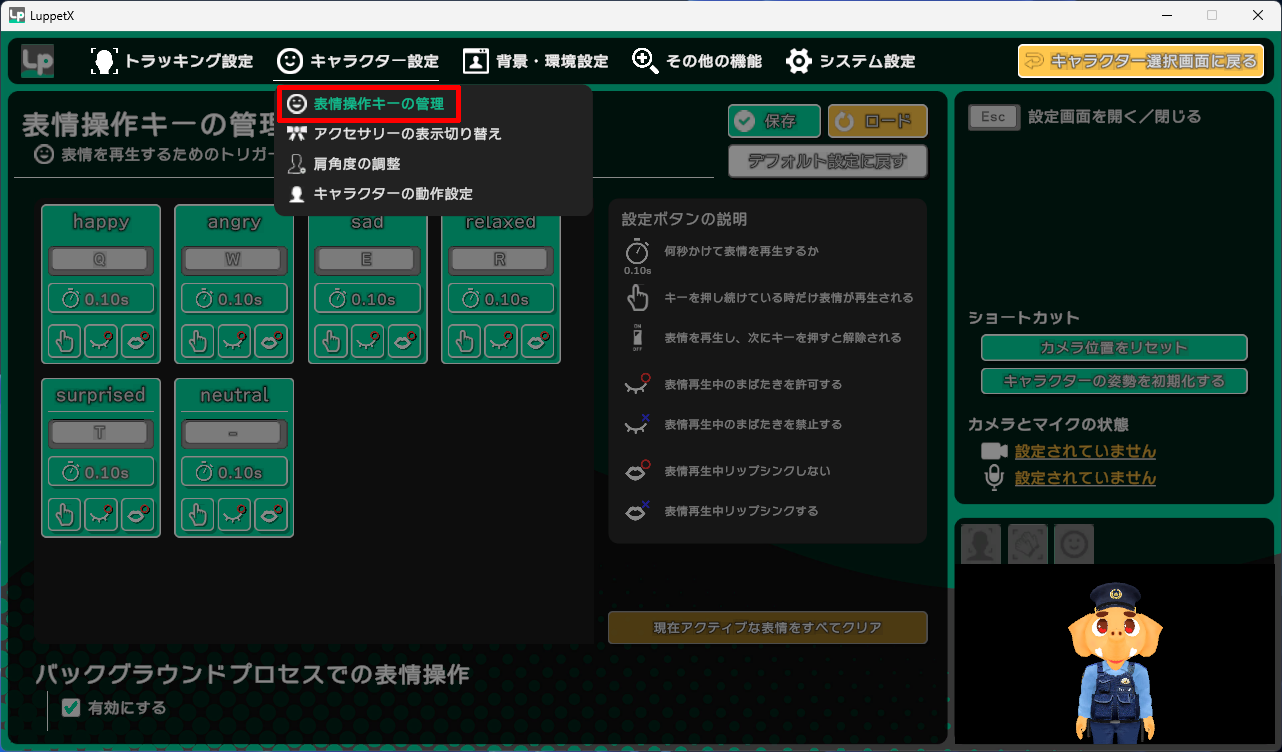

キャラクター設定 > 表情操作キーの管理から、あらかじめアバターに登録されている表情を登録したキーで呼び出すことができます。

自分が決めたキーボードのキーをそれぞれhappy、angry、sad、relaxed、surprised、neutralを割り当てます。

LeapMotion2

顔のトラッキングだけでは少し寂しい感じがしますよね。

手のトラッキングが欲しいところ。

そこで、LeapMotion2というデバイスを使用することで、手、腕のトラッキングができるようになります。

RobotShopというサイトで購入しました。

開封していきたいと思います。

スリーブの中に、2つの箱が入っていました。

大きい方はUSB-Cのケーブルと小さい方はLeapMotion2本体です。

1m50cmくらいのUSB-CケーブルとLeap2です。

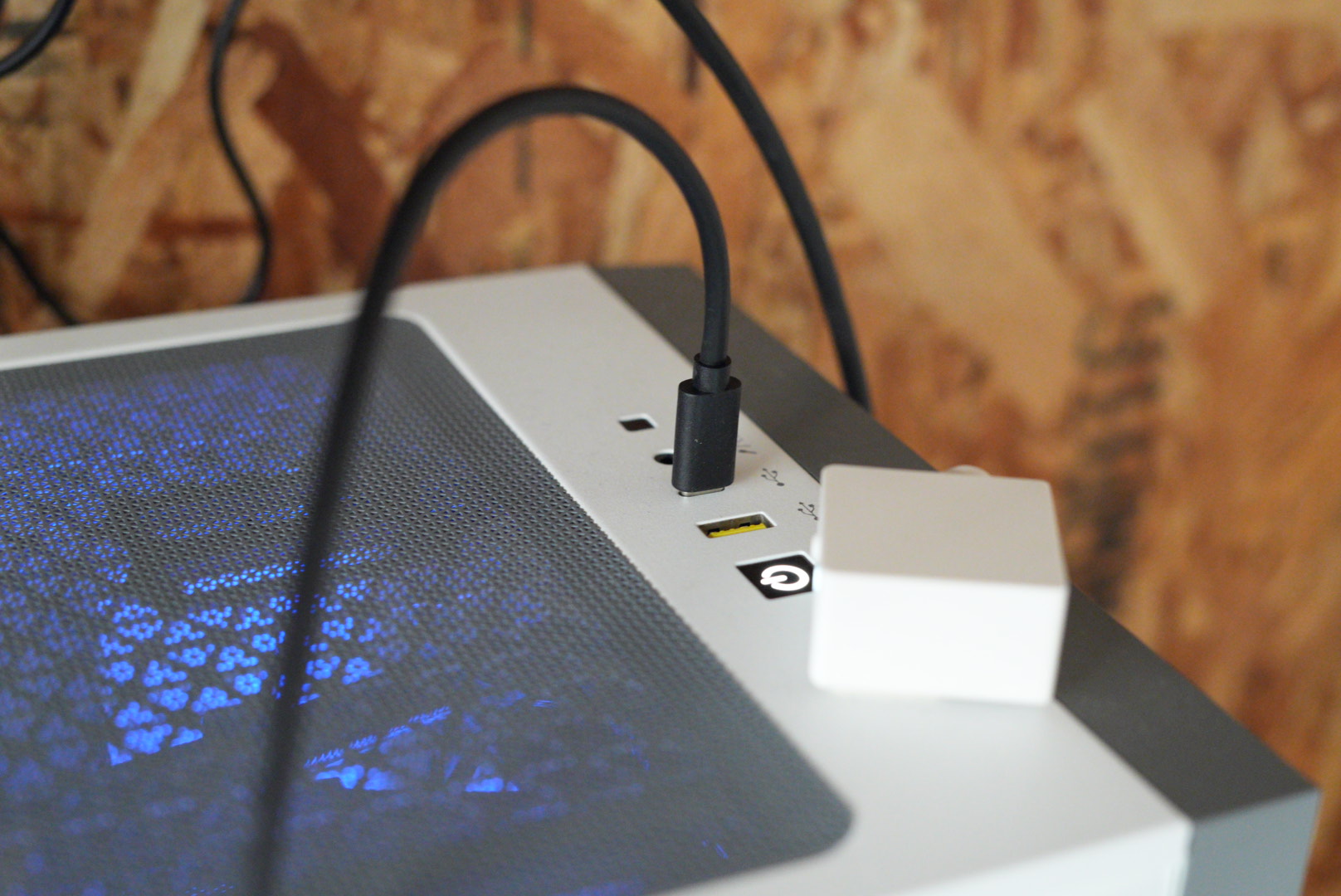

近くで見るとこんな感じです。

反対側にはUSB-Cコネクタがあります

裏面はこんな感じ、両端の丸いのはゴムでできていて滑り止めになっているようです。

PCにつなげてみましょう。

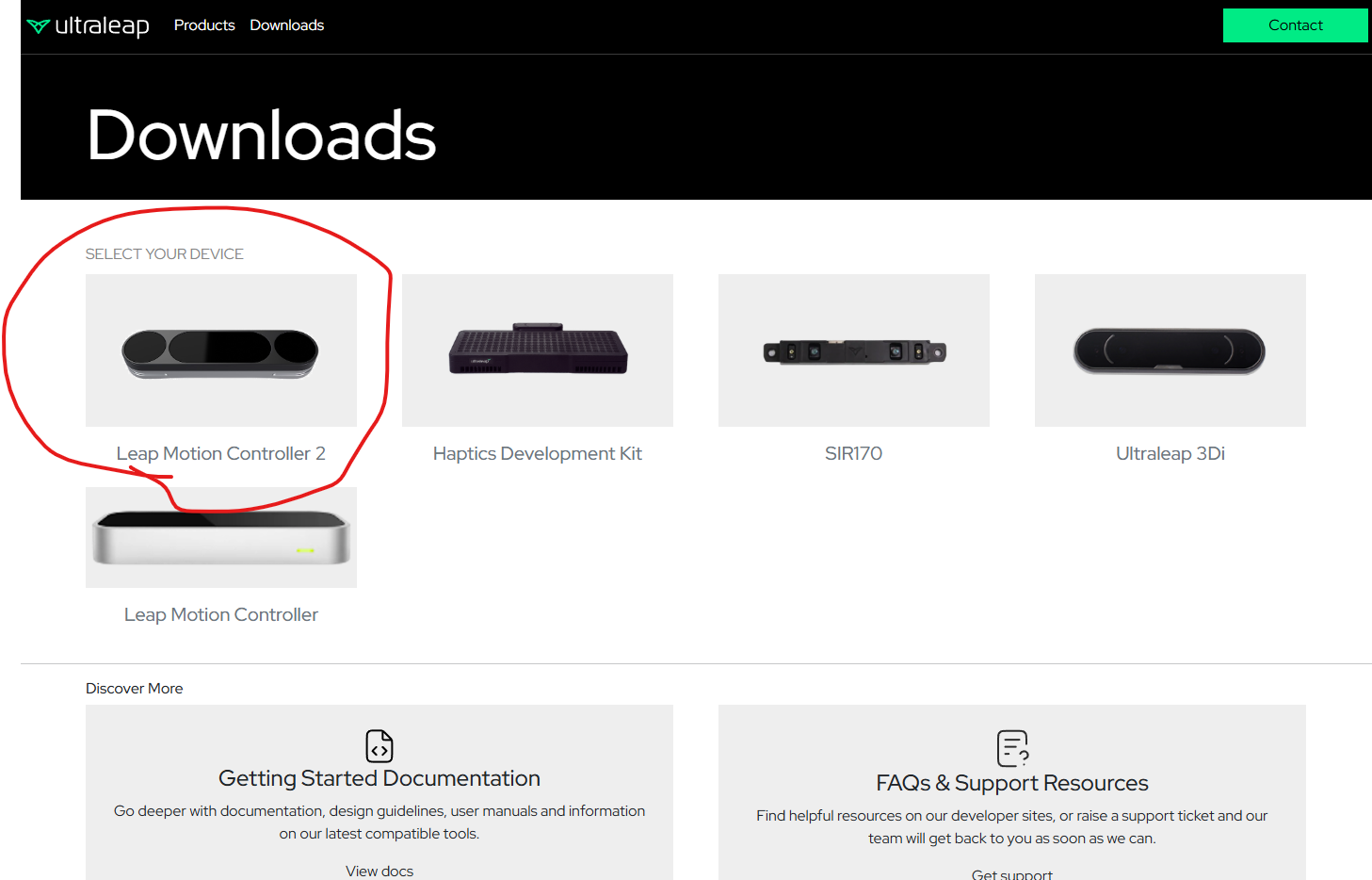

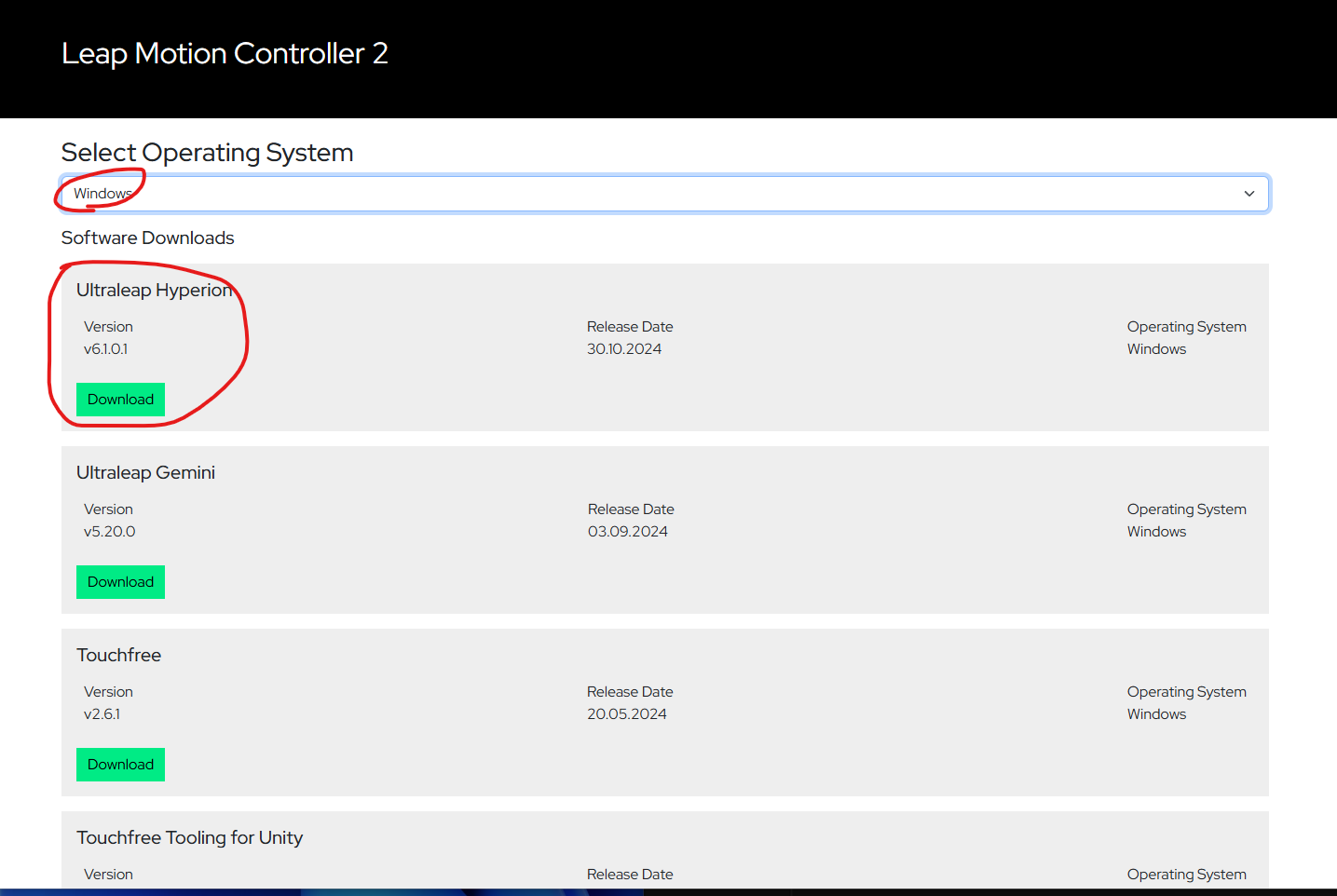

使用するにはUltraleap Hyperionというソフトウェアが必要です。

各自対応したプラットフォームをダウンロードしてください。

Windows用をダウンロードしました。

PC側にもUSB-Cコネクタがないといけないですね。ない場合は、USB-CをUSB-TypeAに変換するアダプタを使用するといいかもです。

ここで思わぬトラブル発生!

Windows11のPCで、LeapMotion2デバイスがUltraleapの画面にカメラが認識できないトラブルが起こりました。

ネットで調べると、同じような症状の方がいるみたい( ; ; )

僕が持っているM1のMacでは認識したので、デバイスは壊れていないようです。

Windows側でドライバ関係が邪魔をしているのか、いろいろ試してみました。

注)いくつか試しました。結果、見事つながるようになりました。

しかし、どれが正解かわかりませんので、とりあえず試した事を書いておきます。

これで、全ての方が治るかわかりませんのでその点はご了承くださいませm(_ _)m

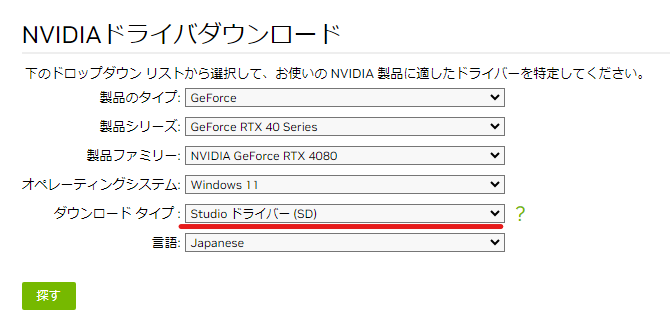

試してみたこと1

NVIDIAのドライバをいったんすべて削除し新しくダウンロードしました。

その時に、ダウンロードタイプをStudioドライバーにしました。

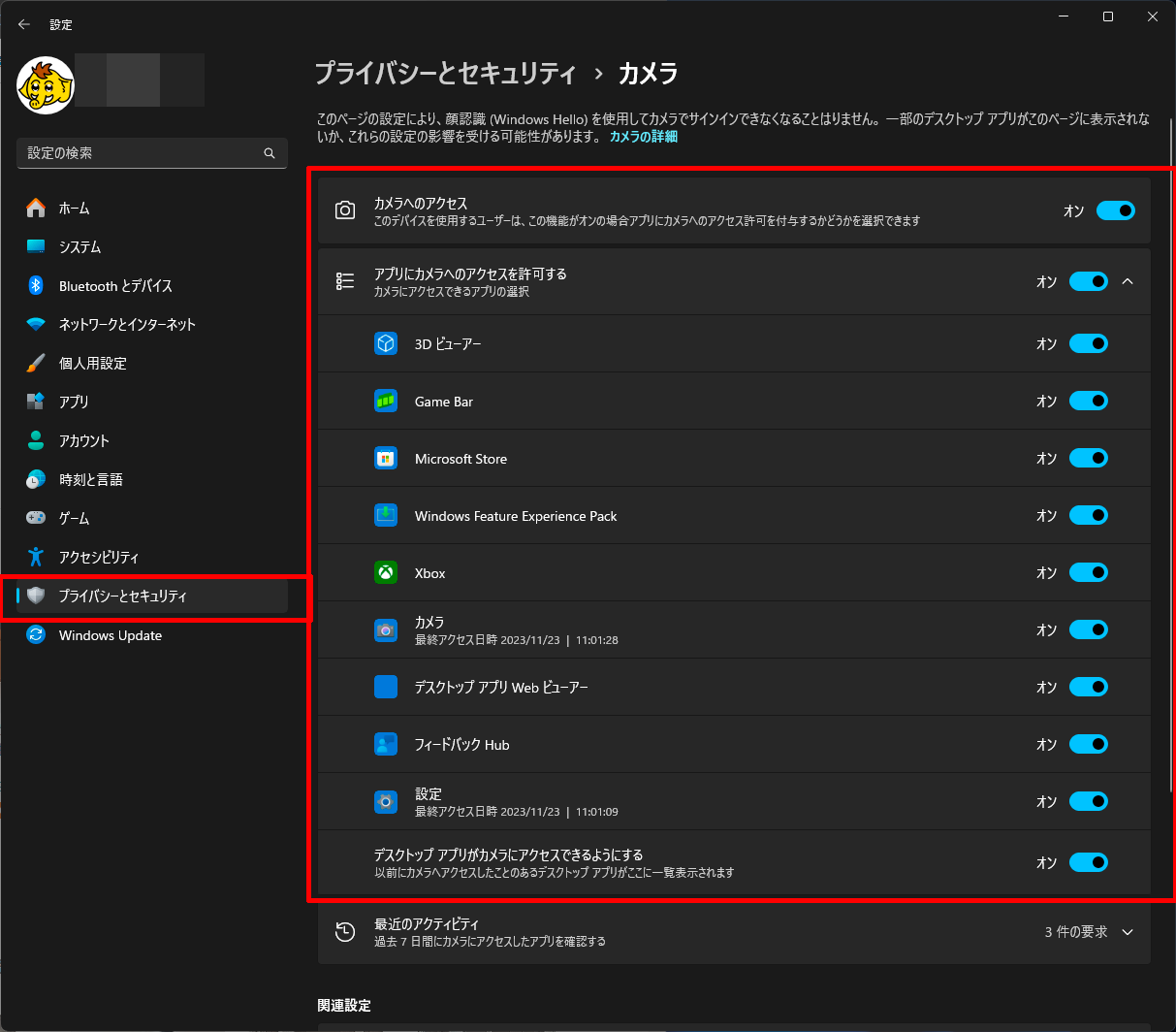

試してみたこと2

プライバシーとセキュリティ > カメラのカメラへのアクセスをオンにしました。

これが原因大じゃないかと思います。

アクセスがなぜかオフになっていたのでオンにしました。

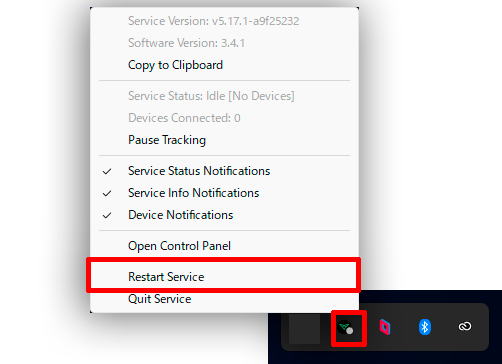

試してみたこと3

下のツールバーのUltraleapを右クリックし、Restart Serviceをする。

これで、見事使えるようになりました。

これで、無事Windows11で使えるようになりましたが、次に、LeapMotion2の取り付け方法が独特なので、ご紹介します。

本来、GoProやスマホ用のネックマウントアダプタですが、これを使用します。

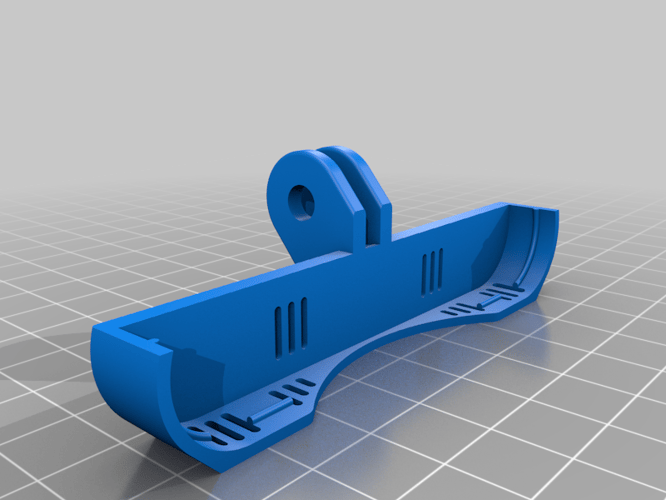

thingiverseのサイトでネックマウント用の3Dモデルデータが、有難いことにありました!

3Dプリンタをお持ちの方であればLeapMotion2用のケースを作ってみるのもいいかもしれませんね

Boothでも、Leap Motion Controller 2用ネックマウンタを販売されている方がいるようですね。こちらは、マウントアダプタ自体を送ってくださるようですので、有料ですが、3Dプリンタがない方には、いいと思います。

僕は、thingiverseのサイトでダウンロードしたモデルを 3Dプリントで出力しました!

このような感じになりました!すごくよくできた3Dモデルでした!

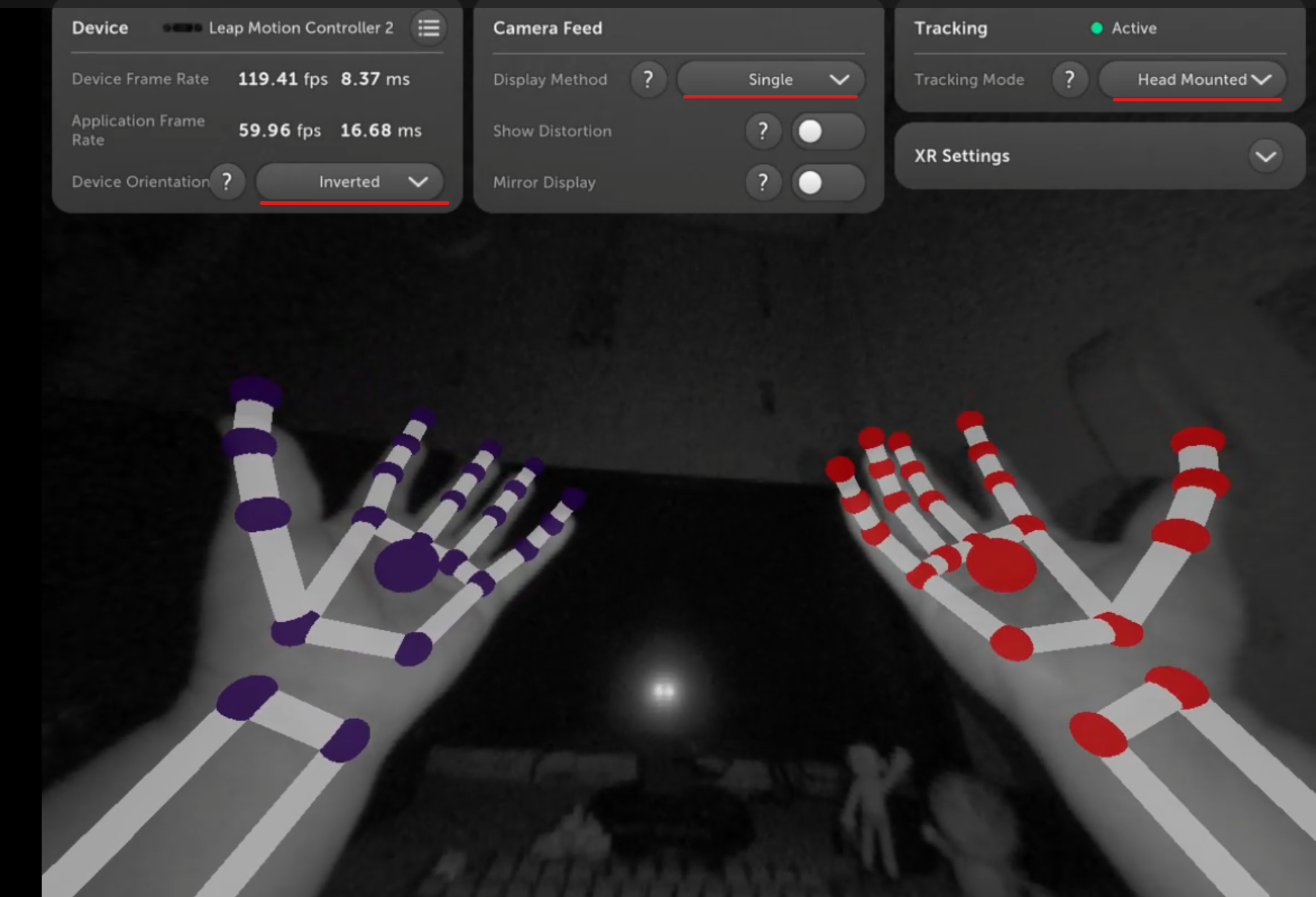

Ultraleap Control Panelを立ち上げるとこんな感じに手を認識することができました。

いくつか設定事項があります。

・Device OrientationをInvertedにしました。(LeapMotionのUSBコネクタが下で使用している場合、逆さに移りますのでInvertedで画面を反転させます。)

・Display MethodをSingleにします。

・TrackingをHeadMountedにします。

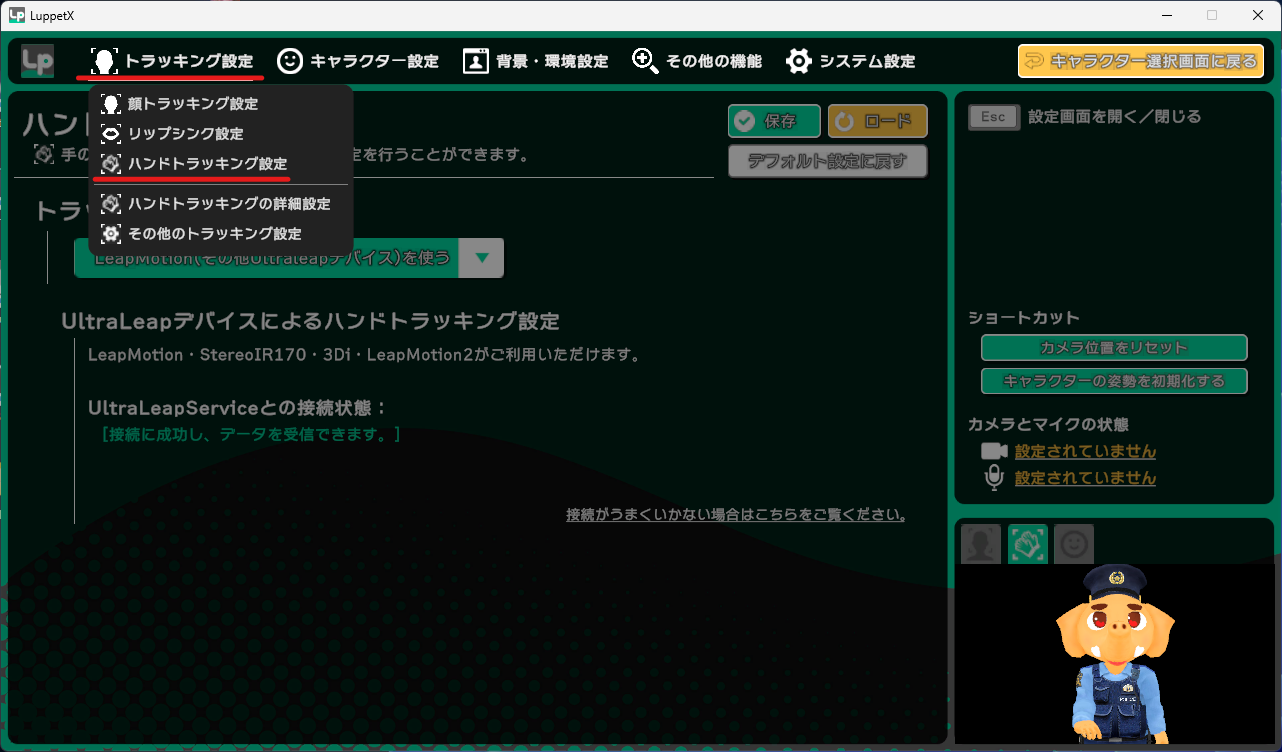

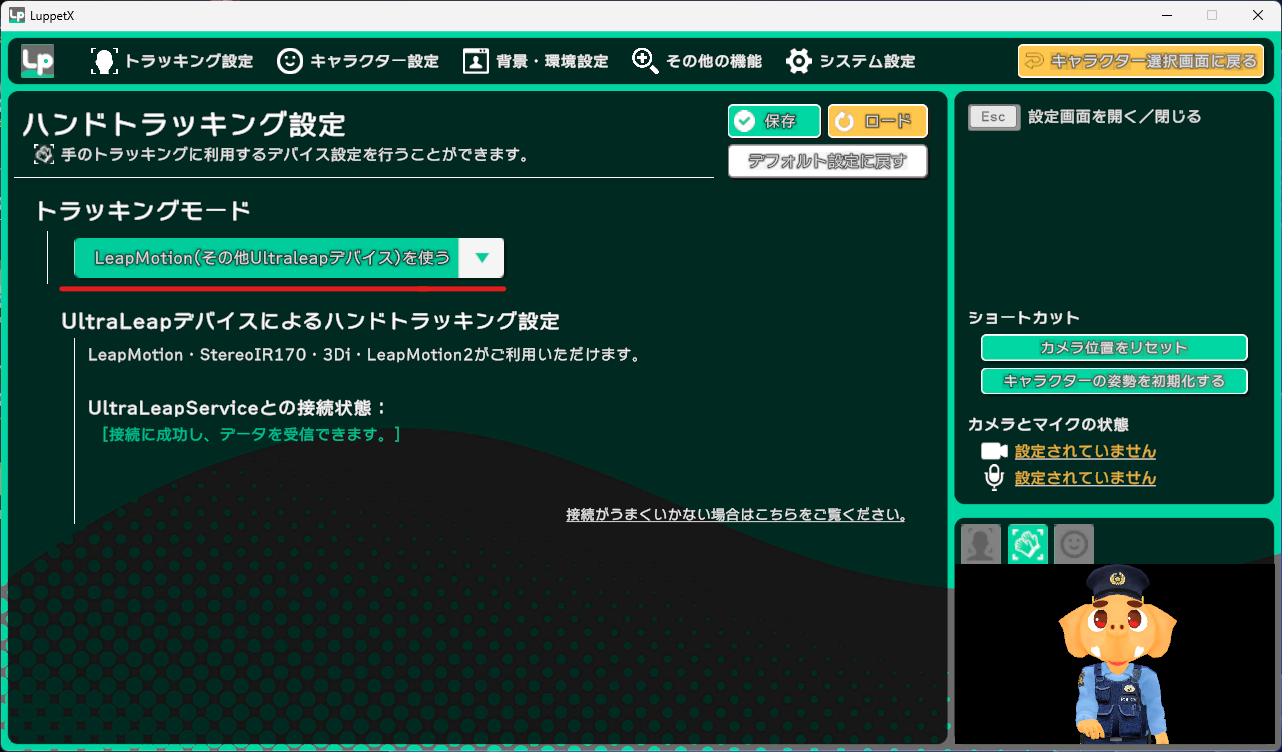

LuppetXで、トラッキング設定> ハンドトラッキング設定を選択

トラッキングモードをLeapMotionにします。

これで、LuppetXで、手を動かすことができるようになります。

OBSで配信や録画をしてみよう

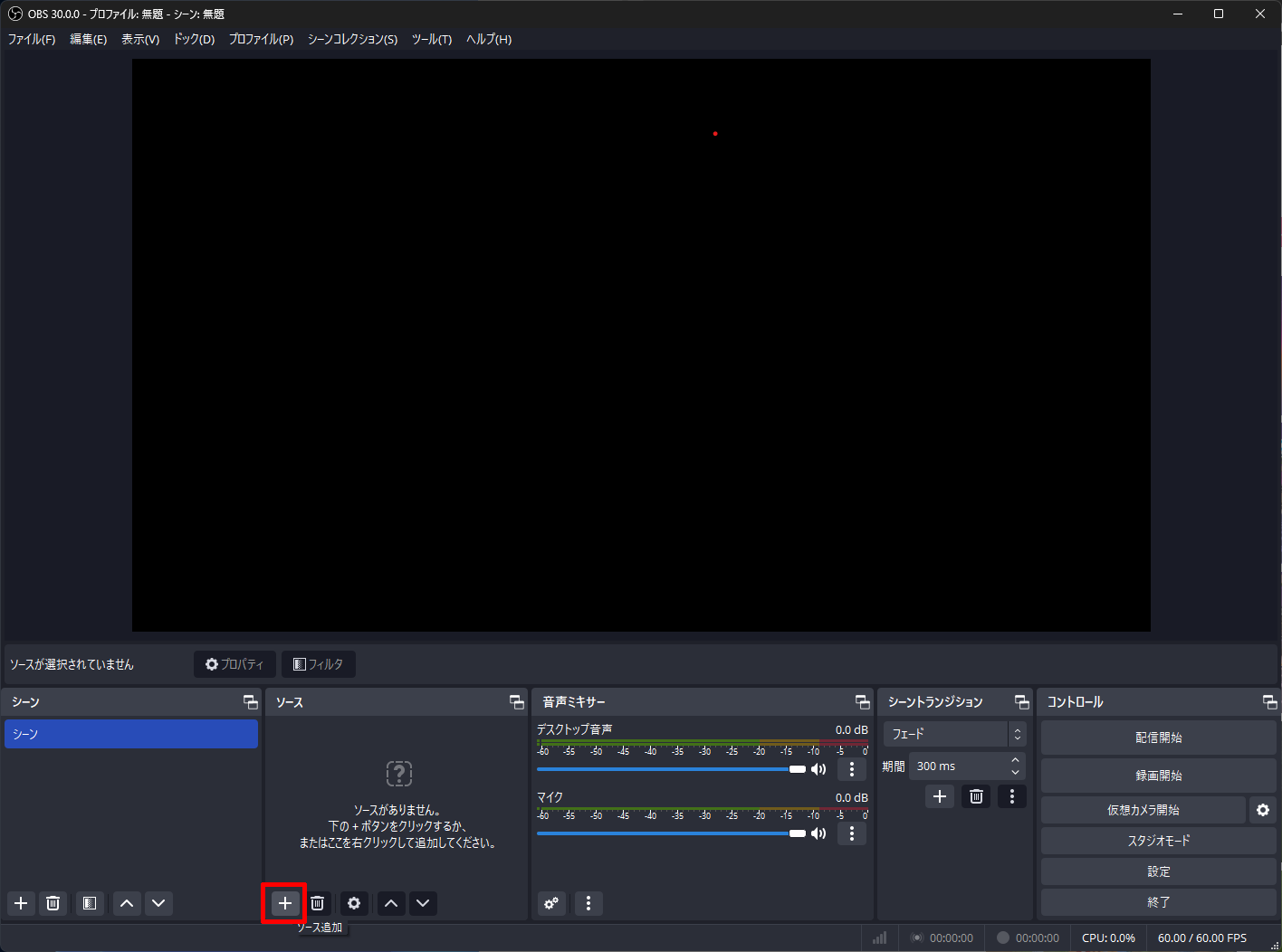

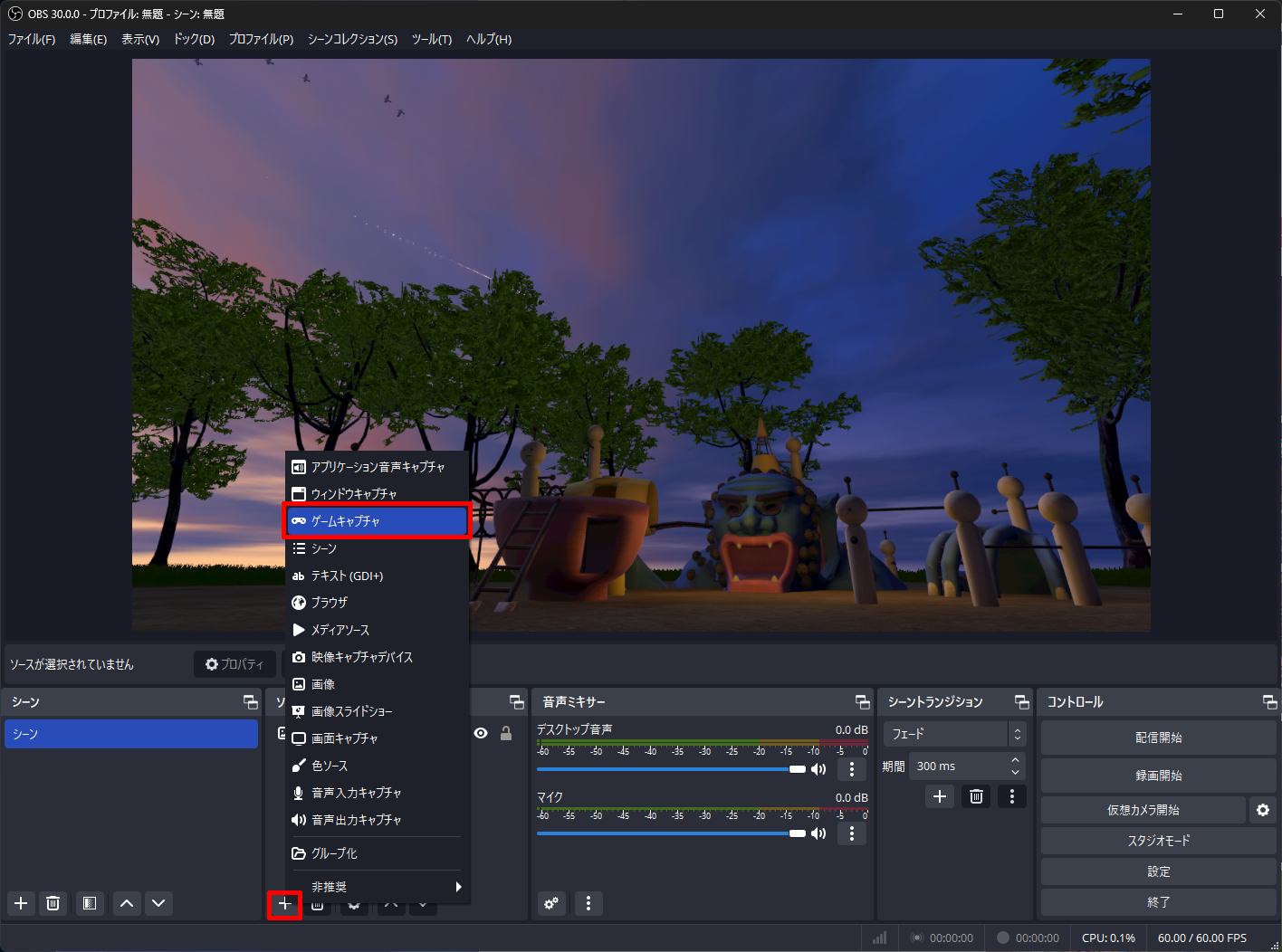

続きまして、今度はOBSのソフトを立ち上げます。

ソースの+ボタンから追加をしてみます。

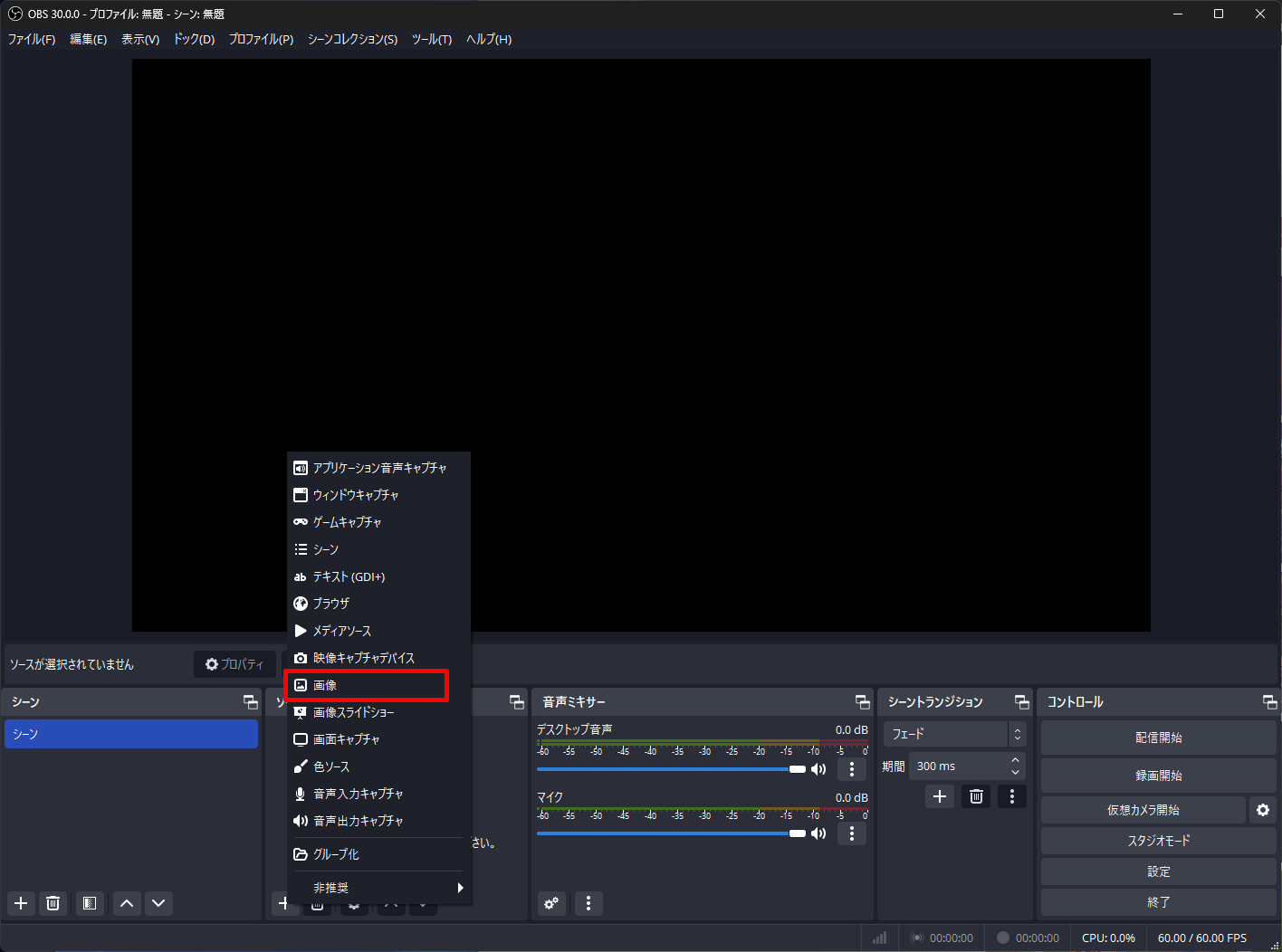

背景が寂しいので、何か画像をいれてみたいとおみます。+から画像を選択します。

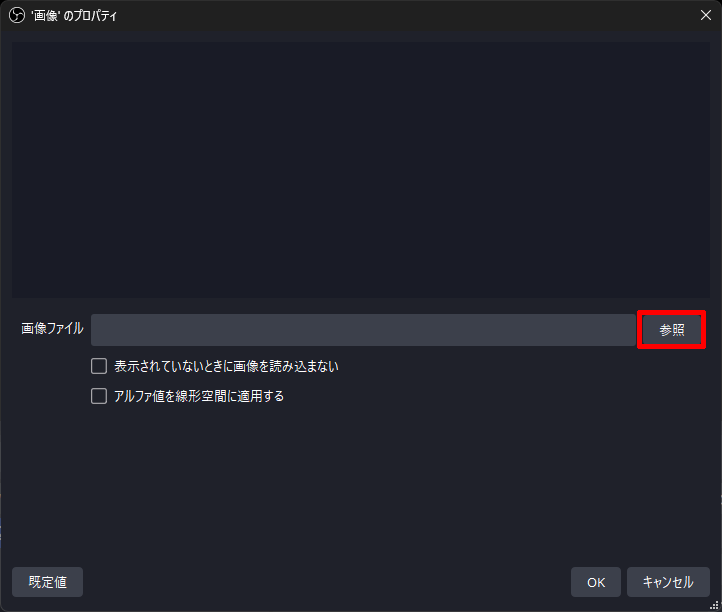

画像プロパティウィンドウが表示されますので参照から画像を選びます。

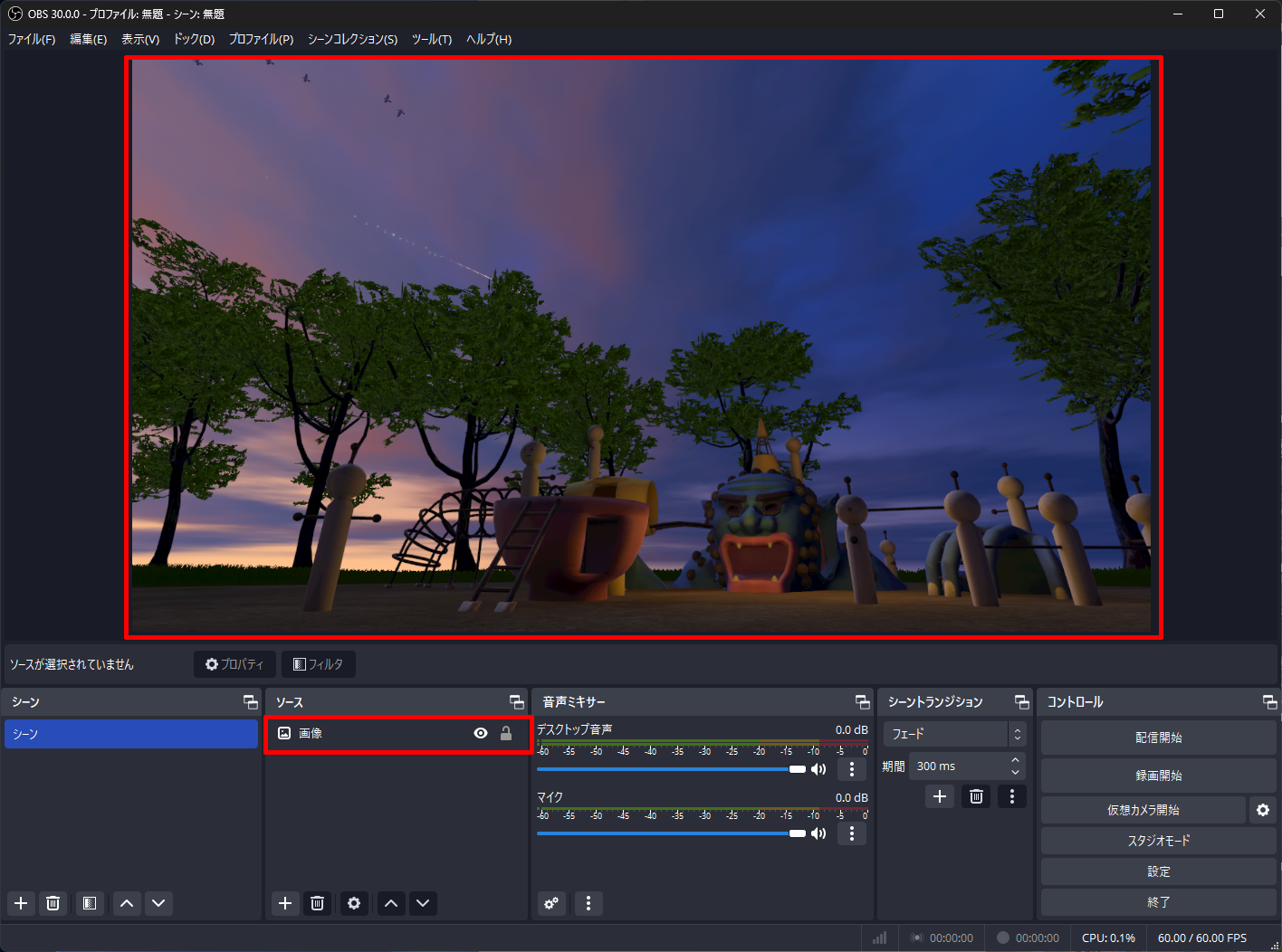

画像が表示されました。

この上に、もう一度+をクリック、今度はゲームキャプチャを選びます。

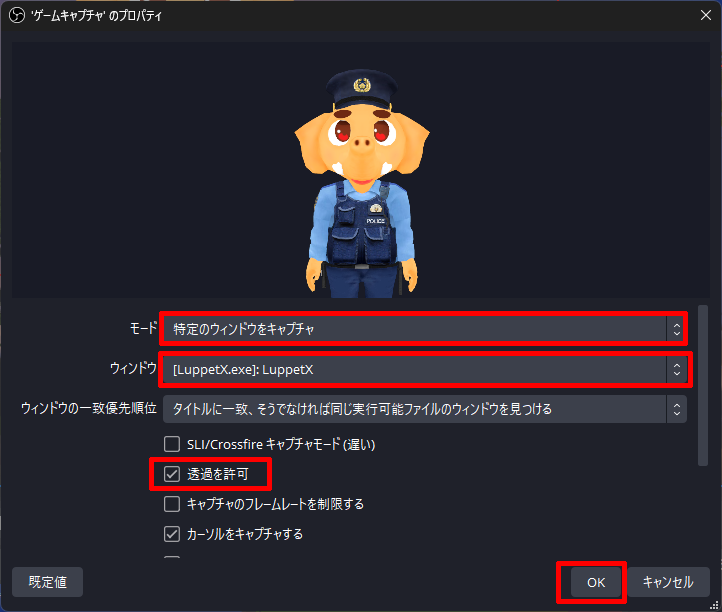

ゲームキャプチャのプロパティから、モードを特定のウィンドウをキャプチャにし、ウィンドウをLuppetXにします。

透過を許可にチェックをいれます。

すると、背景画像の上に、アバターが乗っかった映像になりました。

これで、コントロールの配信開始、録画開始をクリックすれば、顔や口を動かしながら配信することができます。

最後に、メタバースプラットフォームCluster上で、Vtuberっぽいのを作ってみましたのでよかったらご覧ください~。

最後までご覧いただきありがとうございました!